Dossier documentaire et son corrigé

Document 1. Inflation mesurée et inflation ressentie

Depuis plusieurs années, en France (comme d'ailleurs dans de nombreux autres pays), la pertinence de l’indice des prix à la consommation (IPC) est fortement remise en cause. Une large fraction de l'opinion considère en effet qu'il sous-estime nettement l'inflation.

L'enquête de conjoncture auprès des ménages (CAMME) confirme ce décalage. Depuis 2004, elle demande une estimation quantitative de l’inflation à un échantillon d’environ 2 000 ménages. Ces opinions personnelles sur l’inflation (OPI) apparaissent à la fois très dispersées et en moyenne très supérieures à l’inflation mesurée par l'indice des prix à la consommation: les enquêtés attribuent fréquemment à l'inflation des valeurs de 15, 20 voire même 25 % par an. Si on raisonne en moyenne, l'écart est en permanence de l'ordre de 6 points sur toute la période allant de janvier 2004 à décembre 2010.

Comment rendre compte de tels écarts ? […]

On peut d’abord imaginer que les individus construisent leur opinion de manière très globale. Au lieu de s’appuyer sur une observation fine des prix, pondérés par les parts de biens dans leurs budgets personnels, ils exprimeraient une vision synthétique de la situation économique : elle reflèterait les flux d’informations auxquels ils sont exposés, mais également le degré de confiance qu’ils ont dans la qualité de ces informations. Dans ce cadre, l’épisode du passage à l’euro aurait joué un rôle particulier. Il a conduit à un certain nombre de hausses de prix ponctuelles mais fortement médiatisées, et il a en même temps brouillé les repères quantitatifs usuels des consommateurs. Dans une telle situation, un climat de défiance s’est créé autour de la mesure objective de l’inflation et l’écart OPI/IPC serait l’expression de cette défiance.

Toutefois, cette distorsion induite par le passage à l’euro aurait dû progressivement s’atténuer avec le temps. Plus globalement, ce type d’explication rend assez mal compte du parallélisme entre évolutions de l’OPI et de l’IPC qu’on observe depuis 2004. Par exemple, l’IPC et l’OPI s’élèvent simultanément à partir de la fin 2007, puis ils décroissent parallèlement en 2009 et 2010 sous l’effet de la récession et de la baisse corrélative du prix du pétrole et des produits alimentaires. […]

Comment expliquer dans ce cas l’écart entre OPI et IPC ? On peut imaginer que les opinions ordonnent correctement les prix élémentaires, mais soient, en revanche, affectées d’un biais uniforme à la hausse. Ce type d’explication ne fait toutefois que déplacer le problème. Si erreurs de perception il y a, quel est le facteur qui pourrait expliquer que ces erreurs soient systématiquement orientées dans le même sens ?

Ceci oriente vers une autre interprétation. Elle part de l'idée, a priori peu contestable, que le consommateur et l'institut statistique suivent les prix pour des raisons très différentes. Ce dernier a pour mission officielle de mesurer, sur une période donnée et de façon exhaustive et homogène, les mouvements de tous les prix, aussi bien de ceux des produits en baisse que de ceux des produits stables ou en hausse, et ceci indépendamment des innovations et des améliorations de la qualité des produits existants. Le but que poursuit le consommateur en s’informant sur les prix dans sa vie quotidienne est tout autre. Sa surveillance ne tend ni à l’exhaustivité ni à l’homogénéité. Assez naturellement, on peut d’abord supposer qu’elle porte davantage sur les produits qui font l’objet des achats les plus fréquents. Par ailleurs, on peut avancer l'idée que le consommateur contrôle ses dépenses en étant plus attentif aux évolutions de prix à la hausse que de ceux stables ou à la baisse, car seuls les premiers menacent son budget actuel.

Source : « L’inflation telle qu’elle est perçue par les ménages », INSEE Analyses n°5, juillet 2012

Questions :

- En quoi le passage à l’euro a-t-il pu conduire les ménages à surestimer l’inflation ?

- L’inflation ressentie est-elle totalement déconnectée de l’inflation réelle ?

- Quelles sont les différentes explications aux écarts mesurés entre inflation ressentie et inflation réelle ?

Document 2

Questions :

- Quelles sont les différentes phases d’évolution de l’inflation en France ?

- Quelles explications peut-on apporter à l’accélération de l’inflation à partir du milieu des années 1960 ?

- Quelles explications peut-on apporter à la faible inflation des années 2000 ?

Document 3. Quelques plans de lutte contre l’inflation en France

Les plans Giscard d’Estaing (1963-1969)

1963 : blocage des prix ; réduction des hausses de salaires dans la fonction publique ; nouveaux impôts (plus-values foncières, hauts revenus, tiercé) ; encadrement du crédit ; emprunt de 2 milliards ; réduction du déficit budgétaire pour 1964 de 7 à 4,7 milliards de francs

1969 : nouveau blocage des prix […] ; réduction des dépenses publiques et de la création monétaire ; hausse des taux d’intérêt ; dévaluation de 12,5 % (un dollar = 5,50 francs) et contrôle des changes

Les plans Barre (1976-1978)

1976 : blocage des prix (4ème trimestre 1976), gel des tarifs publics au premier semestre 1977, norme de 6,5 % de hausse des prix et des salaires pour 1977 ; réduction des investissements publics ; majoration exceptionnelle de l’impôt sur le revenu, hausse de l’impôt sur les signes extérieurs de richesse, hausse des taxes (alcool, vignette auto) ; moindre croissance de la masse monétaire (+ 12,5 % en 1977 contre 16 % en 1976), hausse du taux d’escompte ; fixation de la valeur des importations pétrolières à 55 milliards […]

Source : Pierre Bezbakh, Inflation et désinflation, collection Repères, La Découverte, 2011

Questions :

- Qu’est-ce que le « blocage des prix » ?

- Pourquoi réduire l’augmentation des salaires peut-être un moyen de lutter contre l’inflation ?

- A travers ces deux plans, trouvez les principaux instruments de lutte contre l’inflation et indiquez leurs fondements théoriques.

Document 4. L’ « invention » du chômage

La notion de ce que sera le chômage moderne s’élabore entre les années 1880 et 1910. Au cours de cette période, dans les grandes villes, un salariat dépourvu de protection et sujet au chômage de masse se généralise, surtout lors des crises économiques. Ce chômage devient la « question sociale » de ces années-là. Les réformateurs sociaux qui se penchent sur elle tentent, d’une part, d’identifier les chômeurs parmi ceux qui ne travaillent pas et, de l’autre, de définir les causes du chômage […] Quel est l’enjeu ? Il s’agit, techniquement, de distinguer les pauvres des sans-emploi – qui jusque-là se confondaient – en définissant selon un critère incontestable la disposition d’un individu à travailler. Entre le début et la fin des

années 1880 on passe du classement des sans-emploi dans la catégorie « chômeurs » à la détermination des causes du chômage en distinguant des catégories de phénomènes et de populations. Ainsi, Charles Booth catégorise les sans-emploi en vrais chômeurs ou inaptes à l’emploi. […] Cette étape est rendue possible grâce aux liens qui unissent ces réformateurs aux réseaux auxquels ils appartiennent. D’où l’importance d’étudier et de prendre en compte cette « nébuleuse réformatrice », élaboratrice de concepts et d’outils et intermédiaire, notamment lorsqu’on envisage les relations entre l’État et le marché. Les développements de la science sociale aboutissent à définir le chômage comme fait social. C’est le deuxième fait marquant de cette période qui constitue, selon Christian Topalov [auteur de Naissance du chômeur : 1880-1910 en 1994], une « révolution scientifique » grâce à deux ouvrages parus en 1909 : Unemployment: a Problem of Industry de l’économiste William Beveridge et Le chômage et la profession du sociologue durkheimien Max Lazard. Pour ces auteurs, le chômage n’est plus vu comme résultant de la responsabilité du chômeur, il n’est plus envisagé en termes individuels et moraux mais est considéré comme un phénomène industriel, social et objectif. Il ne s’agit dès lors plus de classer les chômeurs mais les différentes formes de chômage, ni d’additionner des individus mais de mesurer un fait social en utilisant des indices, ce qui induit une nouvelle définition de l’objet de la statistique. Le chômage devient un fait social dès lors qu’il est attribué à la situation industrielle […] À partir de ce constat, l’objectif est de créer un salariat régulier pour les besoins de la rationalisation du travail et de la production de masse qui fait ses débuts. Comment ? Il s’agit d’abord de classer les individus pour « séparer les chômeurs dignes d’accéder à l’emploi, d’un résidu à réprimer ». Ce classement aboutit aux propositions politiques des réformateurs, concrétisées par la création de nouvelles administrations. Celles-ci donnent des droits aux travailleurs réguliers qui sont définis juridiquement en une catégorie nouvelle, le chômeur « authentique » ou « involontaire ». À ces droits, correspond le devoir de s’établir dans le salariat. Ce constat étant effectué, le placement est rationalisé via la création de bureaux de placement publics. La création de l’assurance chômage permet au chômeur de bénéficier d’indemnités ou d’allocations grâce à ses contributions. Enfin, des travaux de secours ou des travaux publics sont mis sur pied s’il n’est pas possible de placer le chômeur de manière rationnelle. La question du chômage est donc définie autour des années 1910, ce qui permet la mise en œuvre des méthodes et des politiques qui seront appliquées par la Grande-Bretagne, la France et les États-Unis entre les années 1910 et 1930, avec de grandes différences. Pour la France, le chômage enregistré est élevé dans la grande industrie où le salariat ouvrier est important et où la rationalisation est introduite. […] la France connaît un chômage intense et chronique, sélectif, régionalisé et sectorisé. Ainsi, en France le taux de chômage serait voisin de 10 % en 1936 en agrégeant le chômage recensé et le chômage partiel [celui des employés à domicile notamment, non comptés comme chômeurs], contredisant l’image d’une France épargnée.

Source : Jérôme Gautié, « De l’invention du chômage à sa déconstruction », Genèses 1/2002, n°46

Questions :

- Quelle est la distinction faite entre les chômeurs et les sans-emplois au début du XXème siècle ? Cette distinction est-elle toujours valable ?

- Que signifie le fait que le chômage devienne considéré comme un « fait social » ?

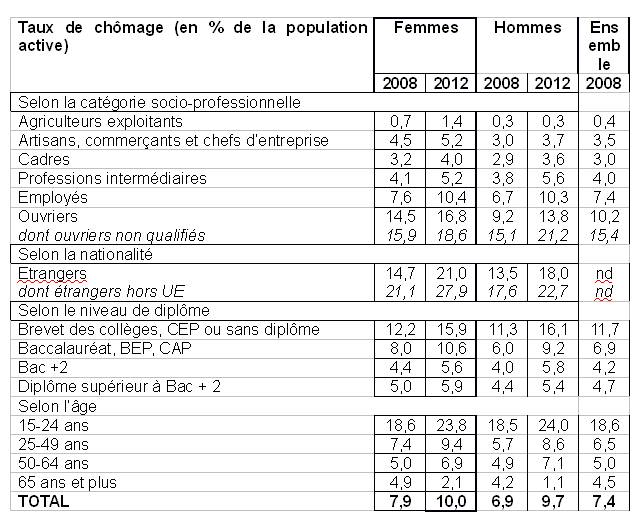

Documents 5 : Taux de chômage selon les caractéristiques des individus

Nd : non disponible

Champ : population de 15 ans et plus

Source : INSEE, Enquêtes emplois 2008 et 2012

Questions :

- Comment peut-on expliquer le taux de chômage élevé des 15-24 ans ?

- La qualification joue-t-elle sur le chômage ? Comment peut-on l’expliquer ?

- Comment a évolué le chômage entre 2008 et 2012 ? Comment peut-on l’expliquer ?

- Comment peut-on expliquer le taux de chômage plus élevé des étrangers ?

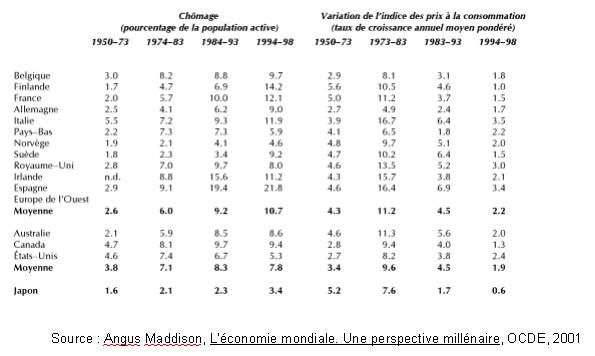

Document 6. Chômage et inflation dans plusieurs pays de l’OCDE (1950-1998)

Questions :

- Comment a évolué le chômage pour la plupart des pays sur la période considérée ? Quels sont les pays qui ne suivent pas l’évolution générale ?

- Mêmes questions pour l’inflation.

- Peut-on dire que l’analyse de la courbe de Philips est vérifiée après 1974 ?

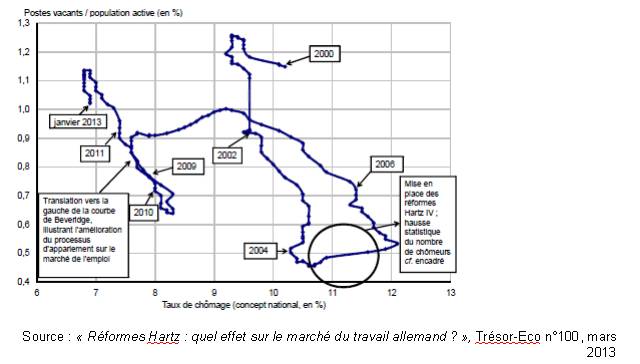

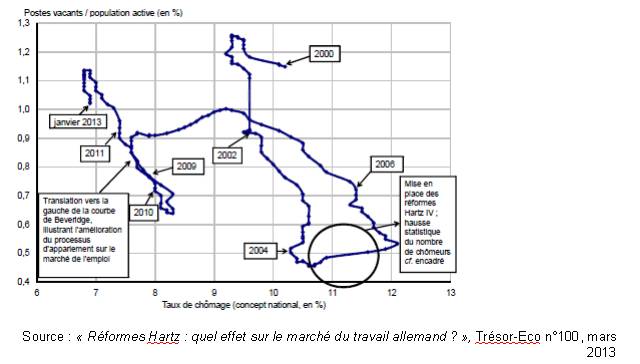

Document 7. Une estimation de la courbe de Beveridge pour l’Allemagne

Questions :

- Observe-t-on une corrélation entre emplois vacants et taux de chômage ?

- Que sont les « réformes Hartz » ? Pourquoi la quatrième a-t-elle pu augmenter le taux de chômage ?

- En quoi un déplacement vers la gauche de la courbe illustre-t-il l’amélioration du processus d’appariement sur le marché de l’emploi ?

- Quelles nuances peut-on apporter au bon fonctionnement du marché du travail allemand ?

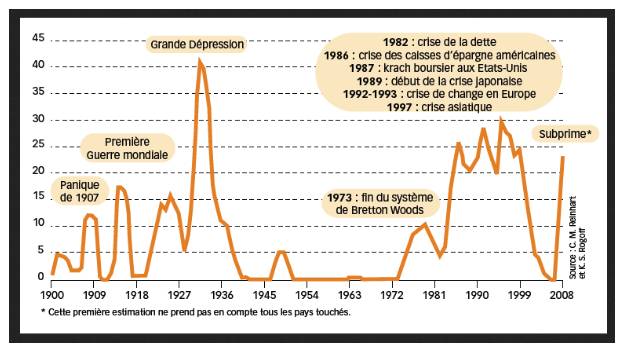

Document 8. Les crises bancaires depuis 1900

Note : Sur l’axe des ordonnées est figuré le poids dans le PIB mondial des pays touchés par une crise bancaire (en % du PIB mondial).

Source : Christian Chavagneux, « L’éternel retour des crises », Alternatives économiques HS n°34, 2009

Questions :

- Relevez les différentes phases d’évolution des crises financières depuis 1900.

- Présentez et expliquez le déroulement de la crise asiatique de 1997.

- Qu’appelle-t-on la fin du système de Bretton Woods ? Quel lien peut-on faire entre cet évènement et la haute fréquence des crises depuis 1980 ?

Document 9. Les accords de Bâle

Lundi 3 octobre [2012] encore, les valeurs bancaires ont fait figure de souffre-douleur des marchés financiers. A la Bourse de Paris, le Crédit agricole a cédé 3,84 %, BNP Paribas 4,64 % et la Société générale 5,15 %. La franco-belge Dexia, rattrapée par une affaire

d'emprunts toxiques vendus à des municipalités françaises, a plongé de 10,16 %. Toutes ces banques font l'objet d'une défiance généralisée : on leur reproche notamment de ne pas avoir assez de fonds propres pour compenser leur exposition à des actifs risqués, telles les dettes grecque, italienne ou portugaise. Depuis les années 1970, les banques ont pourtant été incitées à se doter d'un cadre réglementaire et prudentiel suffisamment strict pour éviter non seulement les faillites, mais aussi leurs répercussions sur d'autres secteurs de l'économie.

C'est en 1974 que voit le jour la volonté d'inciter les banques à harmoniser leurs pratiques et à respecter des normes communes de sécurité. Cette année-là, le secteur bancaire a frôlé la catastrophe : la faillite de la banque ouest-allemande Herstatt a fortement ébranlé le marché des changes – paralysant jusqu'au système des paiements interbancaires de New York – et a failli entraîner la chute de plusieurs autres établissements. Fort heureusement circonscrite, la chute de Herstatt a mis en évidence les risques systémiques liés à une internationalisation de plus en plus poussée des banques.

Peu après cette faillite, un directeur de la Banque d'Angleterre, Peter Cooke, propose la réunion d'un comité réunissant les banques centrales et des organismes de réglementation et de surveillance bancaire des pays du G10 (France, Belgique, Canada, Italie, Japon, Luxembourg, Allemagne, Pays-Bas, Suisse, Espagne, Suède, Royaume-Uni, Etats-Unis). Sa proposition est adoptée et ce comité se réunit dorénavant à Bâle (Suisse) quatre fois par an, sous l'égide de la Banque des règlements internationaux (BRI).

Le Comité n'a qu'une autorité morale sur les banques et institutions financières : il édicte des recommandations et des bonnes pratiques. Leur application est laissée à l'appréciation des Etats membres. Par exemple, les Etats-Unis sont réputés pour traîner des pieds lorsqu'il s'agit de mettre en œuvre les recommandations : les accords de Bâle II y ont été quasiment passés à la trappe. Washington a néanmoins accepté, en 2010, d'appliquer les règles de Bâle III, qui devraient entrer en vigueur en 2013.

L'audience du Comité est en fait bien plus large que le seul groupe des membres fondateurs. La première publication du comité, intitulée "Concordat de Bâle", est élaborée en 1975 et revue en 1983. Elle pose le principe d'une surveillance consolidée d'un groupe bancaire ou financier, y compris pour des établissements financiers qui ne font pas l'objet d'une supervision par les autorités du pays d'origine. […]

Les premiers travaux de grande ampleur du Comité aboutissent à la publication, en 1988, d'un accord sur un ratio international de solvabilité, baptisé "ratio Cooke", du nom de l'instigateur du Comité. Ce ratio est au cœur des accords dits "de Bâle I".

Le ratio Cooke est un élément fondateur de la régulation bancaire : il met en évidence le principe selon lequel le financement de chaque risque doit comprendre un certain montant de fonds propres. Cette précaution doit permettre d'assurer la sécurité globale du marché et de minimiser les risques de nature systémique en évitant l'"effet domino".

Le ratio Cooke reflète le rapport entre le montant des fonds propres et celui des encours de crédit : les accords de Bâle 1 le fixent à 8 %. Dans le détail, ce montant se divise en trois catégories : le noyau dur ou TIER 1 (qui doit être de 4 %), les fonds propres complémentaires ou TIER 2, les fonds propres surcomplémentaires ou TIER 3.

Les accords de Bâle I sont fondamentaux pour la réglementation du système bancaire, mais ils se révèlent rapidement insuffisants : ils ne prennent pas en compte les activités hors bilan des banques – une lacune qui ne sera jamais comblée – et ils ne différencient pas assez finement les niveaux de risque pris par les établissements financiers.

En 1995, le scandale de la Barings achève de convaincre le Comité de s'atteler à une révision et un approfondissement des règles. Star de la banque Barings, une des plus vieilles institutions anglaises, Nick Leeson, à peine 25 ans à l'époque, réalise au début des années 1990 des profits colossaux sur son "desk" de Singapour. Spécialisé dans le trading des produits dérivés, ses gains représentent en 1993 près de 10 % des bénéfices de la banque. Jusqu'à ce que, confronté à des difficultés, il ne se mette à dissimuler ses pertes dans un compte d'erreurs, le désormais célèbre compte 88 888. Ignorées par le contrôle totalement défaillant de la banque, les pertes s'accumulent jusqu'à représenter près de la moitié du capital de la Barings. […]

Un peu plus tard, au début des années 2000, plusieurs scandales comptables ébranlent les Etats-Unis. Enron, WorldCom, Arthur Andersen, autant de société devenues célèbres pour avoir chuté à la suite d'accusations de comptabilité falsifiée. Parallèlement aux accords de Bâle II sont alors élaborées de nouvelles normes comptables applicables à l'échelle mondiale, les normes IFRS (International financial reporting standards).

Publiés en 2004, les accords de Bâle II proposent, à l'aune des récentes turbulences, d'intégrer le risque "opérationnel" (fraudes et défaillances informatiques) dans son cadre d'analyse et d'améliorer la perception du risque de crédit en s'intéressant de plus près à la qualité des emprunteurs.

Cette nouvelle salve d'accords se décline en trois volets.

Exigence de fonds propres : Bâle II prend donc en compte les risques opérationnels et des risques de marché, au lieu de se cantonner aux risques de crédit. Le ratio Cooke est de fait remplacé par le ratio McDonough, du nom du président en exercice du Comité, William J. McDonough, qui prévoit que les fonds propres de la banque soient supérieurs à 8 % des risques de crédits (85 % du ratio) + des risques de marché (5 % du ratio) + des risques opérationnels (10 % du ratio).

Surveillance de la gestion des fonds propres : les banques peuvent fixer des ratios prudentiels encore plus élevés dans les domaines qui leur semblent importants pour leur stratégie, à charge ensuite pour elles de prouver que leurs fonds propres sont suffisants.

Transparence des marchés : des règles sont établies quant à l'information mise à la disposition du public sur l'actif, les risques et leur gestion. L'uniformisation et la transparence des règles bancaires impliquent une uniformisation de la présentation des portefeuilles de risque, ce qui permet à ces portefeuilles d'être lus et compris dans tous les pays où la banque fait des affaires.

Point important, les accords de Bâle II font la part belle à la notation financière et réaffirment son importance pour bien évaluer les risques. Cependant, les accords prévoient que cette notation peut être soit effectuée par des agences (Standard & Poor's, Fitch, Moody's... très décriées aujourd'hui), soit réalisée en interne avec des méthodologies propres. En aucun cas les accords n'imposent le recours aux agences de notation.

Pourtant bien étoffés, les accords de Bâle II n'empêcheront pas la déroute financière de 2008. La faillite de Lehman Brothers, dont les actifs étaient pourtant très bien notés, n'aurait pas dû se produire si les accords avaient correctement fonctionné. Encore aurait-il fallu qu'ils soient appliqués ! En effet, Bâle II n'est jamais entré en vigueur outre-Atlantique... Mais ils ont toutefois fait la preuve de leur insuffisance par ailleurs et une révision à la lumière des enseignements de la crise s'impose.

Les accords de Bâle III, finalisés en décembre 2010, ont dans leur ligne de mire les activités hors bilan des banques – notamment sur les produits dérivés – et leurs fonds propres, qui apparaissent comme de plus en plus insuffisants par rapport aux risques pris par les banques sur les marchés. Les risques pesant sur la liquidité sont également abordés.

Source : Audrey Fournier, « De Herstatt à Lehman Brothers : trois accords de Bâle et 35 ans de régulation bancaire », Le Monde.fr, 03 octobre 2011

Questions :

- Qu’appelle-t-on des « fonds propres » ?

- Comment les banques ont-elles pu contourner le ratio Cooke ?

- Pourquoi le ratio Mc Donough fait-il intervenir les agences de notation ?

- En quoi consistent les accords de Bâle III ?

Document 10. Le « concours de beauté » de Keynes

On pourrait supposer que la concurrence entre les professionnels compétents, doués d’un jugement plus sûr et de connaissances plus étendues que la moyenne des investisseurs privés, corrigerait les fantaisies des individus ignorants livrés à leurs propres lumières. Or il se trouve que l’énergie et l’habileté des investisseurs professionnels et des spéculateurs s’emploient surtout ailleurs. En fait, la plupart d’entre eux se soucient beaucoup moins de faire à long terme des prévisions serrées du rendement escompté d’un investissement au cours de son existence entière que de deviner peu de temps avant le grand public les changements futurs de la base conventionnelle d’évaluation [de la valeur de l’action]. Ils se préoccupent, non de la valeur véritable d’un investissement pour un homme qui l’acquiert afin de le mettre en portefeuille, mais de la valeur que le marché, sous l’influence de la psychologie de masse, lui attribuera trois mois ou un an plus tard. Et cette attitude ne résulte pas d’une aberration systématique, elle est la conséquence inévitable de l’existence d’un marché financier organisé […]. Il ne serait pas raisonnable en effet de payer 25 pour un investissement dont on croit que la valeur justifiée par le rendement escompté est 30, si l’on croit aussi que trois mois plus tard le marché l’évaluera à 20.

Pour l’investisseur professionnel, c’est donc une obligation impérieuse de s’attacher à anticiper ceux des changements prochains dans l’ambiance et l’information que l’expérience fait apparaître comme les plus propres à influencer la psychologie de masse du marché. […] Cet assaut d’intelligence pour anticiper de quelques mois la base conventionnelle d’évaluation plus que pour prévoir de longues années à l’avance le rendement escompté d’un investissement ne suppose même pas qu’il y ait dans le public des pigeons pour emplir la masse des professionnels ; la partie peut être jouée par des professionnels entre eux. Point n’est besoin non plus qu’aucun persiste à croire ingénument que la base conventionnelle d’évaluation a une valeur réelle quelconque à long terme. Il s’agit peut-on dire, d’une partie de […] vieux garçon ou de chaise à musique1, divertissements où le gagnant est celui qui cède la main ni trop tôt ni trop tard […]

Ou encore, pour varier légèrement la métaphore, la technique du placement peut être comparée à ces concours organisés par les journaux où les participants ont à choisir les six plus jolis visages parmi une centaine de photographies, le prix étant attribué à celui dont les préférences s’approchent le plus de la sélection moyenne opérée par l’ensemble des concurrents. Chaque concurrent doit donc choisir non les visages qu’il juge lui-même les plus jolis mais ceux qu’il estime les plus propres à obtenir le suffrage des autres concurrents, lesquels examinent tous le problème sous le même angle. Il ne s’agit pas pour chacun de choisir les visages qui, autant qu’il peut en juger, sont réellement les plus jolis ni même ceux que l’opinion considérera comme tels. Au troisième degré où nous sommes déjà rendus, on emploie ses facultés à découvrir l’idée que l’opinion moyenne se fera à l’avance de son propre jugement. Et il y a des personnes, croyons-nous, qui vont jusqu’au quatrième ou cinquième degré ou plus encore.

Source : John Maynard Keynes, La théorie générale de l’emploi, de l’intérêt et de la monnaie, 1936

Note : le jeu du « vieux garçon » est un jeu de carte connu aussi sous le nom de « pouilleux » ou de « mistigri » : le but est de se débarrasser de toutes ses cartes en n’étant pas le dernier à détenir le « vieux garçon » (le valet de pique en général). Le jeu de la chaise à musique est plus connu sous le nom de « chaises musicales ».

Questions :

- Qu’est-ce qu’une convention selon Keynes ?

- Le comportement des spéculateurs est-il irrationnel selon Keynes ?

- A partir du modèle proposé par Keynes, comment peut-on comprendre l’existence de bulles spéculatives sur les marchés financiers

Document 11. La taxe sur les transactions financières

Presque 80 ans après la proposition de John Maynard Keynes de taxer les transactions à Wall Street, 40 ans après celle de James Tobin de placer quelques grains de sable dans les rouages trop bien huilés de la finance mondiale, l'idée de taxer les transactions financières n'a jamais autant été d'actualité. La France en août

2012, puis l'Italie en mars 2013 ont décidé de taxer les échanges de titres et prochainement, c'est à onze que les pays de la zone euro vont appliquer le projet de taxe de la commission européenne. Les opposants à la taxe sur les transactions financières – nombreux bien sûr parmi les professionnels de la finance, mais aussi parmi les économistes – font valoir qu'elle serait contre-productive : loin de réduire l'instabilité des marchés, cette taxe contribuerait à augmenter la volatilité en diminuant la liquidité. Pourtant, dans leur ensemble, les études empiriques ne décèlent aucun effet sur la volatilité (ni dans un sens, ni dans l'autre), malgré la baisse des volumes de transaction. De même, la taxe française introduite en août 2012 a certes induit une baisse des volumes, mais sans que cela n'ait d'effet sur la volatilité des titres concernés. Pour la première fois, vraisemblablement à partir de 2014, une taxe sur les transactions financières (TTF) à un niveau supranational va voir le jour. Onze pays de la zone euro ont en effet décidé d'appliquer, dans le cadre d'une procédure de coopération renforcée, une taxe de 0,1% sur les échanges d'actions et d'obligations, hors introduction en bourse, et de 0,01% sur les échanges de produits dérivés. Selon la proposition de la Commission européenne, la taxe s'appliquera dès lors qu'au moins un des participants à la transaction est établi dans l'un des onze pays qui l'ont adoptée ("principe de résidence") ou dès lors que la transaction implique un instrument financier émis dans l'un de ces pays ("principe du lieu d'émission"), et ce quel que soit l'endroit où la transaction a lieu. Les transactions entre institutions financières (banques, sociétés d'assurance, fonds de placements, hedge funds…) ne seraient pas exemptés. Cette taxe pourrait rapporter près de 35 milliards d'euros par an. Cette "taxe Tobin" à l'européenne suscite de vifs débats. L'idée de taxer les transactions financières est particulièrement populaire dans l'opinion, mais essuie aussi d'ardentes critiques : le plus souvent ses opposants la jugent contre-productive. Naturellement, les professionnels de la finance sont les premiers à monter au créneau. Ainsi, par exemple, dans son communiqué du 9 janvier 2012, la Fédération Bancaire Française considérait que cela "pèserait sur la croissance, entraînerait une perte de compétitivité et constituerait un lourd handicap pour le financement de l'ensemble de l'économie." […] La taxe sur les transactions financières est entrée en vigueur en France le 1er août 20129. Cette taxe vise principalement les échanges d'actions (ou assimilés) des entreprises dont le siège social est situé en France et dont la capitalisation boursière dépasse 1 milliard d'euros10. Son taux est de 0,2% (contre 0,1% initialement prévu) et elle est redevable par tous les intervenants, quelle que soit leur nationalité et leur localisation. La liste des entreprises concernées est fixée chaque année par un arrêté publié au Journal Officiel : en 2012, les titres en capital de 109 sociétés sont assujettis.

Source : « Taxer les transactions financières n’a pas d’incidence sur la volatilité des marchés », La lettre du CEPII n°331, mars 2013

Questions

- Quel est le principe de la « taxe Tobin » ? Quelle est son application en France ?

- Pourquoi certains économistes et hommes politiques pensent-ils que la taxe peut diminuer la compétitivité des marchés concernés ?

- Pourquoi la taxe sur les transactions financières diminue-t-elle le volume des transactions sur les marchés ?

- Pourquoi le fait de diminuer la liquidité sur les marchés financiers risque-t-il d’augmenter la volatilité ? Est-ce ce qu’on observe selon le CEPII ?

Corrigé

Document 1. Inflation mesurée et inflation ressentie

1) En quoi le passage à l’euro a-t-il pu conduire les ménages à surestimer l’inflation ?

Le passage à l’euro a pu conduire à la hausse de certains prix, tel que celui de la baguette de pain ou d’autres produits de ce type dont le suivi du prix est fortement médiatisé. Ces hausses de prix peuvent s’expliquer par ce qu’on appelle les « coûts de menu » qui sont les coûts liés à la modification des prix retarde souvent les hausses de prix (étiquetage des produits, modification du catalogue…). Le passage à l’euro a obligé à subir ces coûts. L’euro a pu conduire à la modification de prix « arrondis » (les vendeurs sont allés plus facilement vers des produits à 2 euros, alors qu’auparavant, 10 francs – soit un peu plus d’1 euro 50 – était un seuil). Au départ, il a pu brouiller les repères des consommateurs, peu à l’aise avec une nouvelle monnaie pour comprendre la valeur des produits. Cette perte de repères a pu faire penser à une augmentation généralisée des prix, argument défendu par certains médias et certains hommes politiques.

2) L’inflation ressentie est-elle totalement déconnectée de l’inflation réelle ?

Selon l’INSEE, l’inflation ressentie est toujours supérieure à l’inflation réelle (en moyenne le taux d’inflation ressentie est supérieur de 6 points au taux d’inflation mesuré par les variations de l’indice des prix à la consommation). Cependant, il y a une corrélation entre l’inflation ressentie et l’inflation réelle. L’inflation ressentie mesure bien l’augmentation des prix entre 2007 et 2009 et prend bien en compte la baisse des prix entre 2009 et 2010.

3) Quelles sont les différentes explications aux écarts mesurés entre inflation ressentie et inflation réelle ?

Les consommateurs surestiment toujours l’inflation. Nous avons vu que le passage à l’euro a pu conduire à une surestimation de l’inflation. Selon l’INSEE, cet effet a, toutefois, tendance à s’estomper. Pour expliquer le ressenti des consommateurs, l’INSEE avance l’objectif différent dans la mesure pour l’institut statistique et le consommateur. Ce dernier « mesure » une inflation pour connaître l’évolution de son pouvoir d’achat. Dans cette mesure, qui n’a, naturellement, rien de scientifique, il se concentre surtout sur les produits achetés au quotidien. Or, ce sont les prix de ce type de produits qui ont eu tendance à augmenter le plus vite (prix du carburant, de la nourriture, des titres de transport…). Cela conduit également le consommateur à se focaliser plus sur les hausses que sur les baisses : on se souvient plus des hausses de prix que des baisses.

Document 2. Taux d’inflation annuel en France 1950-2012

1)Quelles sont les différentes phases de l’évolution de l’inflation en France ?

Entre 1950 et 1960, il y a une forte instabilité du taux d’inflation : il dépasse les 16 % en 1951 et est négatif en 1953 puis l’inflation accélère jusqu’en 1958. L’inflation se stabilise à un niveau élevé jusqu’à la fin des années 1960. Le taux d’inflation augmente à partir de la fin des années 60. Le choc pétrolier entraîne une très forte accélération de l’inflation. Le taux d’inflation reste élevé (avec d’importantes fluctuations) jusqu’au début des années 1980. On observe un fort ralentissement de l’inflation ensuite. Le taux d’inflation reste assez faible jusqu’à 2012 (autour de 2 %). Il est à noter qu’il y a eu des taux proches de 0 % en 1998, en 1999 et en 2009.

2) Quelles explications peut-on apporter à l’accélération de l’inflation à partir du milieu des années 1960 ?

L’accélération de l’inflation à partir de 1968 (entre 1967 et 1968 le taux d’inflation passe de 2,7 % à 4,5 % puis 6,5 % en 1969) s’explique en grande partie par une boucle prix/salaires : il y a eu des augmentations de salaires suite aux mouvements de 1968, ces augmentations se sont répercuté sur les coûts de production et sur les prix des entreprises. A partir de 1973, c’est le choc pétrolier qui est en grande partie responsable de la nouvelle montée de l’inflation : l’augmentation de 70 % du prix du baril de brut à des conséquences immédiates pour les consommateurs (augmentation des prix du carburant) et des conséquences indirectes, via l’augmentation des coûts de production. Nous pouvons observer l’effet du second choc pétrolier en 1979.

3) Quelles explications peut-on apporter à la faible inflation des années 2000 ?

La première explication que l’on peut apporter est la priorité accordée à la lutte contre l’inflation : les décideurs politiques et leurs conseillers ne « croient » plus en l’analyse de la courbe de Philips et il n’est alors plus considéré que l’inflation est un « mal nécessaire ». La mondialisation est aussi une explication : elle permet d’importer (ou de produire au sein de multinationales) des produits moins chers et la concurrence des autres pays entraîne une modération des augmentations de salaire (le chômage joue aussi dans ce sens). La lutte contre l’inflation se fait également dans le cadre européen : une inflation modérée fait partie des critères de Maastricht pour l’adhésion à l’Union Européenne puis la lutte contre l’inflation est la priorité de la politique monétaire de la BCE, politique menée avec succès à partir de 1999.

Document 3. Les plans de lutte contre l’inflation en France

1) Qu’est-ce que le « blocage des prix » ?

Le « blocage des prix » est une mesure légale administrative qui empêche l’augmentation des prix au-delà d’un certain seuil ou à partir du niveau qu’ils ont atteint au moment où la décision est prise. C’est une mesure qui n’est prise plus que très rarement, sauf dans des domaines précis : blocage des loyers par exemple. En France, en 2012, l’idée d’un blocage des prix de l’essence a été envisagée.

2) Pourquoi réduire l’augmentation des salaires peut-elle être un moyen de lutter contre l’inflation ?

Le ralentissement des salaires est un moyen d’éviter la mise en place d’une boucle prix/salaires. Elle évite aussi une trop forte stimulation de la demande qui peut être génératrice d’inflation quand l’offre ne suit pas (explication « keynésienne » de l’inflation).

3) A travers ces deux plans, trouvez les principaux instruments de lutte contre l’inflation et indiquez leurs fondements théoriques.

Nous avons vu à la question 2 l’instrument de blocage des prix. Son fondement théorique est simple : pour empêcher les prix d’augmenter, on décide qu’ils n’augmentent pas. Cette mesure est plus difficile à prendre dans le cadre d’une économie fortement ouverte sur l’extérieur. Plusieurs mesures, comme la modération salariale, s’appuient sur l’explication keynésienne de l’inflation. Ce sont toutes les mesures qui s’inscrivent par exemple dans des politiques budgétaires de rigueur : augmentations d’impôts, création de taxes… Nous pouvons voir que plusieurs décisions cherchent à limiter l’augmentation des coûts de production pour lutter contre l’inflation « par les coûts » : on retrouve ici la modération salariale mais aussi les limites dans la valeur des importations de pétrole. Au cours des années 1960 et 1970, la politique monétaire est aussi mise au service d’une lutte contre l’inflation. L’augmentation des taux d’intérêt, le ralentissement de la croissance de la masse monétaire ou encore l’encadrement du crédit ont pour objectif de limiter la création monétaire. Ces instruments s’inscrivent dans la perspective de la théorie quantitative de la monnaie et répondent aussi à l’objectif de limitation de l’augmentation de la demande.

Document 4. L’ « invention » du chômage

1) Quelle est la distinction faite entre les chômeurs et les sans-emplois au début du XXème siècle ? Cette distinction est-elle toujours valable ?

Jusqu’au début du XXème siècle, le terme de chômeur est fortement polysémique. Il est ensuite précisé et distingué de la situation plus générale des personnes sans emplois. Ces derniers peuvent être chômeurs ou inaptes à l’emploi. Les chômeurs sont alors ceux qui peuvent et souhaitent occuper un emploi, ceux qui peuvent être mobilisés pour produire. Cette distinction entre chômage et inactivité est toujours vraie : c’est elle qui pousse à compter les chômeurs parmi les actifs. Le chômeur est celui qui occuperait un emploi s’il en avait la possibilité.

2) Que signifie le fait que le chômage devienne considéré comme un « fait social » ?

La notion de « fait social » renvoie à la méthode sociologique de Durkheim. Pour lui, la sociologie est la science qui étudie les faits sociaux. Considérer le chômage comme un fait social, dans ce sens, c’est cesser de traiter le chômage comme un problème individuel : ne plus s’intéresser à la personne seule du chômeur mais à la question du chômage comme une question collective. Par ailleurs, dans l’analyse durkheimienne, les faits sociaux doivent être expliqués par d’autres faits sociaux : le chômage ne peut être compris comme le résultat de préférences individuelles (analyse néoclassique) mais doit être expliqué par d’autres faits sociaux, tels que l’industrialisation, la baisse de la demande, la mécanisation de l’agriculture…

Document 5. Taux de chômage selon les caractéristiques des individus

1) Comment peut-on expliquer le taux de chômage élevé des 15-24 ans ?

Une partie du chômage des 15-24 ans est un chômage « frictionnel » : les jeunes sont au chômage quand ils sont à la recherche d’un premier ou d’un nouvel emploi. Cette situation est d’autant plus fréquente que les jeunes sont surreprésentés parmi les emplois précaires. Selon la théorie de la segmentation du marché du travail, ils sont plus souvent sur le marché secondaire. La théorie des insiders-outsiders peut nous permettre de comprendre le fort chômage des jeunes qui, par définition, font plus souvent partie des outsiders.

D’un point de vue plus statistique, le taux de chômage est très élevé car la population active de 15 à 24 ans est, plus qu’aux autres âges, est composée en grande partie de travailleurs non ou peu qualifiés (puisque les plus qualifiés finissent leurs études assez tard).

2) La qualification joue-t-elle sur le chômage ? Comment peut-on l’expliquer ?

Nous pouvons constater que les moins qualifiés sont les plus touchés par le chômage. Cela se voit à la fois en termes de diplômes (chômage plus élevé des non diplômés) et en termes de catégories socio-professionnelle (chômage plus élevé des employés et des ouvriers et encore plus élevé des ouvriers non qualifiés). Nous l’avons vu à la question 1, les moins qualifiés sont plus souvent sur le marché secondaire. D'un point de vue néoclassique, le salaire minimum et l’assurance chômage nuisent surtout à l’emploi des moins qualifiés car ils risquent de se situer à un niveau supérieur à leur productivité marginale. On peut également s’appuyer sur l’idée selon laquelle la mondialisation et le progrès technique (théorie d’un progrès technique biaisé en faveur des plus qualifiés) détruisent surtout des emplois non qualifiés (alors que, selon W. Reich, par exemple, les « manipulateurs de symbole » sont protégés). Nous pouvons voir une vérification de ces idées dans le chômage particulièrement élevé des ouvriers non qualifiés qui sont, a priori, les plus vulnérables.

3) Comment a évolué le chômage entre 2008 et 2012 ? Comment peut-on l’expliquer ?

Quelle que soit la catégorie concernée, nous pouvons observer une augmentation du chômage entre 2008 et 2012. Cette augmentation renvoie à l’analyse keynésienne du chômage. La crise économique a déprimé la demande globale et conduit à l’augmentation du chômage « involontaire ».

4) Comment peut-on expliquer le taux de chômage plus élevé des étrangers ?

Nous pouvons constater un taux de chômage beaucoup plus élevé pour les étrangers que pour le reste de la population. Comme pour les jeunes, ce fort taux de chômage s’explique par leur position parmi les outsiders mais aussi par le type de qualification qu’ont ces actifs (avec des actifs peu qualifiés et d’autres dont la qualification est difficile à faire valoir en France). Enfin, il est difficile de ne pas évoquer, pour quelques étrangers, la possibilité d’une discrimination sur le marché du travail.

Document 6. Chômage et inflation dans plusieurs pays de l’OCDE

1) Comment a évolué le chômage pour la plupart des pays sur la période considérée ? Quels sont les pays qui ne suivent pas cette évolution générale ?

Nous pouvons constater une augmentation assez nette du taux de chômage sur la période considérée. Par exemple, en moyenne pour les pays européens, le taux de chômage annuel augmente de plus de 3 points entre la période 1950-73 et la période 1974-83 puis à nouveau de trois points entre cette période et la suivante. Il y a un ralentissement de l’augmentation du taux de chômage mais il est tout de même de 10,7 % de la population active en moyenne chaque année pour les pays européens entre 1994 et 1998. Le chômage suit cette même évolution en France. Peu de pays s’écartent de cette tendance. Le Japon se détache par un taux de chômage qui reste faible sur l’ensemble de la période. Les Etats-Unis, eux, connaissent une diminution de leur taux de chômage moyen à partir de la période 1983-1993.

2 ) Mêmes questions pour l’inflation.

Le taux d’inflation augmente pour la plupart des pays considérés entre 1973 et 1983. Pour les pays européens, en moyenne, le taux d’inflation gagne 7 points environ. L’inflation ralentit fortement sur la période 1983-1993 et le taux d’inflation perd encore quelques points sur la période suivante. En ce qui concerne l’inflation, aucun pays ne se démarque réellement. Il est à noter que le Japon connaît des taux d’inflation particulièrement bas sur la période 1994-1998 : il connaît un épisode de déflation.

3) Peut-on dire que l’analyse de la courbe de Philips est vérifiée après 1974 ?

La période 1974-1983 est une période où coexistent une forte accélération de l’inflation et une augmentation importante du chômage, ce qui contredit l’analyse de la courbe de Philips. C’est ce qu’on a appelé la « stagflation ». Ensuite, le chômage diminue en même temps que l’inflation ralentit dans un certain nombre de pays dont les Etats-Unis. Pour les pays européens, nous pouvons voir que le ralentissement très important de l’inflation s’accompagne d’une forte augmentation du chômage, ce qui semble davantage aller dans le sens de la relation mise en évidence par Philips. Pour certains keynésiens, la stagflation s’explique par le fait que l’inflation est en grande partie importée alors que la lutte contre l’inflation déprime fortement l’activité économique et peut être à l’origine d’un chômage élevé.

Document 7. Une estimation de la courbe de Beveridge pour l’Allemagne

2) Que sont les « réformes Hartz » ? En quoi la quatrième a-t-elle pu augmenter le nombre de chômeurs ?

Les réformes Hartz sont des réformes du marché du travail mises en place sous le mandat du chancelier Schröder, de 2003 à 2005. Leur nom vient du directeur du personnel de Volkswagen, Peter Hartz, qui avait négocié d’importants accords de flexibilité dans son entreprise. La première de ces réformes facilite le recours au travail temporaire (en n’imposant plus de durée maximale de mission) et crée des agences publiques de placement des chômeurs sous la forme de missions d’intérim. Elle renforce les droits et les devoirs des chômeurs en les obligeant, par exemple, à faire la preuve qu’une offre d’emploi n’est pas « acceptable » mais aussi en favorisant la formation. La seconde réforme favorise la création d’entreprises par les chômeurs et crée une convention pour la signature de « Mini-job » (emplois de court terme, souvent de faible durée dans la semaine moins taxés) et de « Midi-job » (emplois de plus longue durée dans la semaine que les mini-job mais peu taxés également). La troisième réforme consiste en une réforme du service public de l’emploi, notamment en favorisant l’autonomie des agences locales et a durci les conditions d’accès à l’assurance chômage. La quatrième réforme est celle qui a la plus grande ampleur. La durée d’accès à l’assurance chômage est limitée à un an, au-delà, le chômeur est un chômeur de longue durée et touche une allocation plus faible et peut être embauché à des conditions plus favorables pour l’employeur. Par ailleurs, l’aide sociale (équivalent du RSA) a été revalorisée en même temps qu’elle a été conditionnée à la signature d’un contrat d’insertion avec l’agence pour l’emploi ou le service communal. Le but de cette réforme est de favoriser l’insertion sur le marché du travail des chômeurs et d’un certain nombre d’inactifs. La quatrième réforme a mécaniquement augmenté le nombre de chômeurs car elle a créé une obligation à s’inscrire auprès des agences pour l’emploi.

3) En quoi un déplacement sur la gauche de la courbe illustre-t-il l’amélioration du processus d’appariement sur le marché de l’emploi ?

Un déplacement vers la gauche de la courbe de Beveridge signifie qu’à un taux équivalent d’emplois vacants, le taux de chômage est plus faible. Cela signifie bien que les emplois vacants sont plus facilement occupés : s’il y a des emplois vacants, c’est plus car il y a peu de chômeurs que parce que personne, parmi les chômeurs ne peut occuper les emplois vacants. Pour l’Allemagne, nous pouvons constater qu’à partir de 2008, il y a un déplacement important de la courbe vers la gauche, puis un déplacement vers le haut sur la courbe : l’appariement s’améliore et la situation sur le marché du travail s’améliore : le taux de chômage diminue fortement.

4) Quelles nuances peut-on apporter au bon fonctionnement du marché du travail allemand ?

Il est important d’observer la bonne situation de l’emploi en Allemagne ces dernières années. En période de crise, le taux de chômage a fortement diminué et le fonctionnement du marché du travail s’est amélioré (voir question 3). Une nuance peut être apportée quant à la « qualité » des emplois occupés. Une partie de la diminution du chômage s’explique par le développement des « Mini-job ». Enfin, pour certains économistes, la démographie peut expliquer en partie la diminution du taux de chômage : une baisse de la population active (ou au moins un ralentissement) crée davantage d’emplois vacants qui peuvent être occupés par des chômeurs. Cela peut cependant, aussi avoir des conséquences négatives puisqu’une baisse de la population active peut diminuer la demande intérieure. Cette dernière, dans le cas allemand, peut être compensée par la demande extérieure.

Document 8. Les crises financières depuis 1900

1) Relevez les différentes phases d’évolution des crises financières depuis 1900.

Nous pouvons constater une période de forte instabilité au début du XXème siècle, marquée par la panique de 1907 (crise boursière de grande ampleur) puis la première guerre mondiale. Cette période atteint son paroxysme avec la crise de 1929 : en 1929 et dans les années suivantes, de nombreuses crises bancaires surviennent. Après la seconde guerre mondiale, on assiste à une période de forte stabilité financière. A partir des années 1970, il y a une montée des crises bancaires. Celles-ci deviennent très fréquentes et d’assez grande ampleur tout au long des années 1980 et 2000. Après un relatif calme à partir de 2005, la crise des subprimes entraîne une forte remontée des crises bancaires, remontée non visible sur ce graphique qui s’arrête en 2009.

2) Présentez et expliquez le déroulement de la crise asiatique de 1997.

A partir des années 1980, l’Asie du sud-est est une région qui connaît une forte croissance économique. Suivant un modèle de développement proche du Japon, les « Quatre dragons » (Singapour, Hong Kong, Corée du Sud et Taïwan) puis l’Indonésie, la Malaisie, les Philippines et la Thaïlande connaissent une forte croissance, alimentée en grande partie par des capitaux étrangers : la plupart de ces pays ont fortement ouvert leurs marchés de capitaux. La forte croissance rend ces marchés très attractifs, ce qui facilite l’endettement élevé des banques et des autres acteurs de l’économie. On observe alors une évolution de l’endettement proche de celle mise en avant par Minsky. A partir de 1997, après plusieurs mauvaises nouvelles dont le creusement du déficit commercial de la Thaïlande et le non remboursement de prêts immobiliers, la défiance gagne ces marchés. Les investisseurs internationaux retirent leurs capitaux (« fuite vers la qualité »), ce qui aggrave les difficultés et crée un mouvement de panique (que l’on peut comprendre avec l’analyse keynésienne). Le FMI doit alors intervenir et les pays laissent flotter leurs monnaies (alors qu’ils avaient le plus souvent opté pour un ancrage au dollar).

3) Qu’appelle-t-on la fin du système de Bretton Woods ? Quel lien peut-on faire entre cet évènement et la haute fréquence des crises depuis 1980 ?

Le système de Bretton Woods est le nom donné au système monétaire international mis en place en 1944. L’objectif de ce système est de favoriser le commerce international tout en évitant l’instabilité monétaire internationale. C’est un système de changes fixes mais ajustables : chaque pays du système ancre sa monnaie au dollar ou à l’or et le dollar, lui-même a un taux de change fixe par rapport à l’or. Le taux de change peut fluctuer de 1 % autour de la parité officielle. C’est dans ce cadre qu’est né le FMI, pour assurer les parités officielles. A partir de 1973, ce système prend fin : la parité du dollar est d’abord suspendue et les accords de la Jamaïque, en 1976, marquent la fin officielle du système de Bretton Woods. Il y a alors la liberté de choix du système de taux de change pour chaque pays : le dollar flotte alors que les pays européens fondent le serpent monétaire européen en 1971 puis le système monétaire européen en 1979. La fin du système de Bretton Woods est une étape importante de dérèglementation des marchés internationaux. Cette dérèglementation s’inscrit dans ce qu’Henri Bourguinat appelle les « 3D », caractéristiques de la globalisation financière : dérèglementation des marchés, décloisonnement et désintermédiation financière (baisse de la part des crédits bancaires dans le financement au profit du financement direct). Ces 3 D facilitent le financement de l’activité économique au niveau international mais ils sont aussi générateurs d’instabilité et renforcent l’interdépendance des économies. On peut ainsi constater que le nombre de crises augmente à partir des années 1980 et qu’elles touchent davantage de pays à chaque fois.

Document 9. Les accords de Bâle

1) Qu’appelle-t-on des « fonds propres » ?

Les fonds propres (ou capitaux propres) sont les ressources propres de la banque, celles qui ne sont pas empruntées. Elles proviennent de l’apport des actionnaires (ou des sociétaires) ou bien des bénéfices. Ce sont ces fonds propres qui interviennent dans la mesure des différents ratios de solvabilité.

2) Comment les banques ont-elles pu contourner le ratio Cooke ?

Le ratio Cooke imposait aux banques d’avoir des fonds propres égaux à 8 % des encours de crédit (encours dont le poids était pondéré par leur risque). Seulement, les encours de crédit qui sont pris en compte étaient ceux inscrits dans le bilan des banques, certains spéculateurs ont pu dissimuler des activités (et surtout des pertes !) dans des comptes « hors bilan ». Une autre limite du ratio tenait dans la mesure du risque des activités.

3) Pourquoi le ratio Mc Donough fait-il intervenir les agences de notation ?

Le ratio Mc Donough est l’une des principales mesures des accords de Bâle II. Il fait intervenir une pondération importante des activités selon le risque encouru dans son calcul. Il s’inscrit également dans une logique de plus grande transparence des activités. Or, pour mesurer les risques, les banques peuvent agir elles-mêmes, mais elles doivent alors mesurer les risques et communiquer dessus ou bien faire intervenir les agences de notation. La crise de 2008 a mis en avant les difficultés des agences de notation pour bien évaluer le risque mais aussi le fait que les accords de Bâle II étaient insuffisamment appliqués et insuffisants.

4) En quoi consistent les accords de Bâle III ?

Les accords de Bâle III résultent des travaux du comité de Bâle suite à la crise de 2008. Ils cherchent à répondre aux limites des accords de Bâle II. Ils imposent par exemple un ratio plus élevé de fonds propres prenant en compte les activités hors bilan et celles à effet de levier. Ils instaurent aussi un ratio de liquidité : les banques doivent pouvoir fournir un certain montant de liquidité en cas de crise, ce qui doit permettre d’éviter les « runs » bancaires.

Document 10. Le « concours de beauté » de Keynes

1) Qu’est-ce qu’une convention selon Keynes ?

Keynes parle de « convention » pour évoquer le fait que face à une situation incertaine les agents économiques se réfèrent aux autres : les comportements se fixent sur un « comportement moyen », comportement conventionnel. Cela permet à Keynes de montrer que, par exemple, l’acheteur d’une action ne se fie pas à ce qu’il estime être la véritable valeur d’une entreprise (ce qu’Eugène Fama, prix Nobel 2013, par exemple appelle la « valeur fondamentale » de l’action) mais à ce que font les autres.

2) Le comportement des spéculateurs est-il irrationnel selon Keynes ?

Si les spéculateurs ne font pas un calcul de la valeur de long terme de l’action selon ses « fondamentaux » (comme on le suppose dans le modèle néoclassique par exemple ou dans l’hypothèse des marchés efficients), ce n’est pas qu’ils sont irrationnels. C’est que la rationalité les pousse à ne pas faire ces calculs mais à suivre les autres : sur les marchés financiers, il vaut mieux se tromper avec tout le monde qu’avoir raison tout seul. C’est l’idée que Keynes défend à la fin du premier paragraphe du document. André Orléan appelle cette rationalité une rationalité « auto-référentielle ».

3) A partir du modèle proposé par Keynes, comment peut-on comprendre l’existence de bulles spéculatives sur les marchés financiers ?

Le modèle de Keynes donne une explication des bulles spéculatives basée sur ce qu’on appelle les « esprits animaux ». Dans un premier temps, la convention se base sur l’idée d’une augmentation du cours de l’action. C’est une « prophétie auto-réalisatrice » : la croyance d’une augmentation des cours conduit les investisseurs à acheter, ce qui augmente le cours de l’action et pousse à l’achat. Il se produit une bulle quand rien ne vient rompre la convention haussière et que certains éléments font penser à une hausse durable (la cotation d’entreprises innovantes, une innovation financière…). Selon Keynes, les spéculateurs savent bien que le marché va se retourner à un moment mais ils n’ont pas intérêt à se retirer tant qu’il y a des profits à espérer (voir question 2). Le but est de se retirer au bon moment : ne pas être dans les derniers à vendre quand la convention change sur les marchés. Il se produit alors le même mouvement dans l’autre sens : la convention se fixe sur une baisse des marchés qui est également auto-réalisatrice : c’est la crise financière.

Document 11. La taxe sur les transactions financières

1) Quel est le principe de la « taxe Tobin » ? Quelle est son application en France ?

La taxe Tobin est une taxe qui frappe les transactions sur les marchés financiers. Elle repose sur le principe d’une taxation assez faible de chaque transaction pour en limiter le nombre et réduire la spéculation de court terme. C’est une idée énoncée par Keynes et qui a été reprise par James Tobin dans les années 1970 pour taxer les opérations sur les marchés des changes. En France, depuis 2012, il existe une taxe sur les transactions financières, qui concerne l’ensemble des ventes et achats d’actions et d’obligations réalisées en fin de journée (ce qui exclut le « trading haute fréquence » puisque les actions et obligations sont alors achetées et revendues – parfois plusieurs fois – dans la même journée). La France a également signé un accord pour la mise en place d’une taxe européenne.

2) Pourquoi certains économistes et hommes politiques pensent-ils que la taxe peut diminuer la compétitivité des marchés concernés ?

La taxe ne s’applique pas sur l’ensemble des marchés. Ainsi, au niveau européen, le Royaume-Uni s’oppose à l’instauration d’une telle taxe. Cela risque d’inciter les spéculateurs à se tourner vers les marchés non taxés.

3)Pourquoi la taxe sur les transactions financières diminue-t-elle le volume des transactions sur les marchés ?

Les spéculateurs sont amenés à comparer le gain espéré d’une vente ou d’un achat et la taxe qu’ils auront à payer : cela les désincite à effectuer certaines opérations. C’est d’autant plus vrai que la taxe est fixée à un pourcentage élevé du montant de l’opération.

4) Pourquoi le fait de diminuer la liquidité sur les marchés financiers risque-t-il d’augmenter la volatilité ? Est-ce ce qu’on observe selon le CEPII ?

Keynes a montré que les investisseurs ont une « préférence pour la liquidité » : ils préfèrent pouvoir se défaire rapidement des titres qu’ils possèdent. C’est d’ailleurs une des raisons de la titrisation, qui rend liquide des crédits établis sur vingt ou trente ans. Si la liquidité diminue, il y a un risque plus élevé de « course vers la liquidité » : à la première difficulté venue, les investisseurs cherchent à se défaire des titres les moins liquides pour ne garder que ceux qui peuvent être rapidement vendus. Selon le CEPII, la taxation sur les transactions financières, si elle diminue bien la liquidité (il devient plus difficile de vendre ses titres) n’a pas augmenté la volatilité.